IndexFiguresTables |

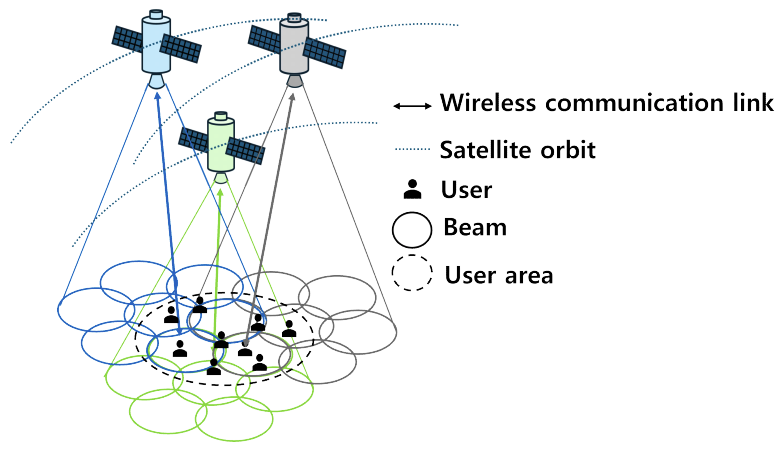

Chungnyeong Lee♦ , Taehoon Kim* , Inkyu Bang** and Seong Ho Chae°Handover Minimization Scheme Using Multi-Agent Deep Reinforcement Learning in Multi-Beam Low Earth Orbit SatellitesAbstract: In this paper, we propose a Multi-AgentProximal Policy Optimization(MAPPO)-based handover strategy for multi-beam Low Earth Orbit (LEO) satellite networks, employing the Centralized Training and Decentralized Execution (CTDE) approach of Multi-Agent Deep Reinforcement Learning (MADRL). The proposed strategy aims to minimize the number of handovers and maximize throughput by considering the cost differences between inter-beam and inter-satellite handovers, user quality of service (QoS) constraints, and load balancing. Each user independently makes handover decisions based on local information (e.g., load and channel conditions within the coverage area), allowing for prompt immediately adaptation to the dynamic and complex environment of multi-beam LEO satellite networks. Simulation results indicate that the proposed algorithm reduces the number of handovers by 39.1% to 75.53% and improves throughput by 14.6% to 157.7% compared to benchmark handover algorithms, thereby objectively demonstrating the superior performance of the proposed approach. Keywords: Low earth orbit satelite , handover strategy , multi-beam , multi-agent deep reinforcement learning 이충녕♦, 김태훈*, 방인규**, 채승호°다중 빔 저궤도 위성에서 다중 에이전트 심층 강화 학습을 활용한 핸드오버 최소화 기법요 약: 본 논문에서는 중앙 집중 학습 및 분산 실행(CTDE, Centralized Training Decentralized Execution) 방식의 다중 에이전트 심층 강화 학습(MADRL, Multi-Agent Deep Reinforcement Learning) 알고리즘인 Multi-Agent Proximal Policy Optimization,(MAPPO) 기반 다중 빔 저궤도 위성 핸드오버 전략을 제안한다. 제안된 방법은 빔간 및 위성 간 핸드오버 발생 시의 비용 차이, 사용자 서비스 품질 제약 조건, 그리고 부하 균형을 고려하여 핸드오버 횟수를 최소화하고 처리율을 최대화하는 것을 목표로 한다. 각 사용자는 국소 정보(커버리지 내 부하 수 및채널 정보)를 바탕으로 독립적으로 핸드오버를 결정하며, 이는 복잡하고 동적으로 변하는 다중 빔 저궤도 위성 환경에 즉각적인 대응을 가능하게 한다. 시뮬레이션 결과, 제안된 알고리즘은 기존 핸드오버 알고리즘에 비해 핸드오버 횟수를 39.1%에서 75.53%까지 감소시키고, 처리율을 14.6%에서 157.7%까지 향상시켰음을 보임으로써, 제안알고리즘의 우수한 성능을 입증하였다. 키워드: 저궤도 위성, 핸드오버 전략, 다중 빔, 다중 에이전트 심층 강화학습 Ⅰ. 서 론최근 저궤도 위성 네트워크는 전 세계적인 커버리지(Coverage)와 끊김 없는 연결을 제공하는 역할로 많은 관심을 받고 있다[1,2]. 저궤도 위성은 낮은 전파 지연 시간과 낮은 에너지 소비와 같은 여러 이점을 제공할 수 있지만, 높은 공전 속도는 지상 사용자가 서비스 받는 동안 빈번한 핸드오버를 불가피하게 발생한다[3]. 특히, 다중 빔 저궤도 위성 환경에서는 사용자에게 여러 빔이 빠르게 지나감에 따라 매우 빈번한 빔 간 또는 위성 간 핸드오버가 발생한다[4]. 따라서, 빔 간 또는 위성 간 핸드오버 발생 비용은 서로 다르므로, 핸드오버 빈도뿐만 아니라 그 비용을 최적화하는 것이 중요하다5. 핸드오버 발생 횟수의 증가는 네트워크 오버헤드(Overhead)가 증가시켜 서비스 품질이 저하되는 문제를 야기할 수 있다. 따라서, 이러한 비용을 최소화하는 다중 빔 저궤도 위성을 위한 핸드오버 전략의 설계가 필요하다. 최근, 저궤도 위성 네트워크에 대해, 다양한 기준과 제약 조건을 가진 핸드오버 기법들이 제안되었다[6-8]. 먼저, 네트워크 흐름 그래프(Network-Flows Graph) 기반의 핸드오버 전략이 저궤도 위성 네트워크를 위해 제안되었다[6]. 여기서, 위성과 사용자 단말 간의 매칭은 제한된 용량과 최대 흐름 조건 하에서 그래프의 비용과 흐름의 곱을 최소화함으로써 결정되었다. Wu 등은 저궤도 위성 핸드오버를 위한 이분 그래프(Bipartite Graph) 프레임워크와 잠재적 게임(Potential Game) 이론 기반 핸드오버 알고리즘을 제안하여, 저궤도 위성 네트워크에서 모바일 단말기의 이득을 극대화하였다[7]. 대규모 사용자 단말을 위한 그룹 핸드오버 전략이 저궤도 위성 네트워크에서 제안되었다[8]. 그러나, 제안된 핸드오버 전략[6]-[8]들은 중앙화된(Centralized) 방식으로 중앙 제어 장치와 글로벌(Global) 정보를 필요로 한다. 이는, 고밀도 저궤도 위성 네트워크에서 더욱 큰 신호 오버헤드(Overhead)를 초래한다. 이와 같은 중앙 집중 방식의 한계를 완화하고자, 저궤도 위성 네트워크에서 분산화(Distributed)된 핸드오버 방식이 제안되었다[9,10]. 다중 에이전트(Agent) 강화 학습 기반 저궤도 위성 핸드오버 전략은 각 위성의 부하(Load) 제약 조건을 만족시키면서 평균 핸드오버 횟수를 최소화하는 방식으로 제안되었다[9]. 연속 심층 Q-학습(Successive Deep Q-Learning) 알고리즘 기반으로 한 분산형 저궤도 위성 핸드오버 방식이 제안되었는데[10], 이는 각 사용자가 핸드오버가 발생할 때, 핸드오버 지연, 실패, 서비스 품질 및 위성 간 트래픽 균형을 고려하여 지역 정보에 기반한 핸드오버 결정을 수행할 수 있도록 한다. 앞서 제안된 중앙화 또는 분산화된 위성 핸드오버 전략[6-10]들은 위성 핸드오버만 고려하였으며, 빔 간 핸드오버는 고려하지 않았다. 그러나 실질적이고 정교한 저궤도 위성 네트워크에서의 핸드오버 설계를 위해서는 위성 간 또는 빔 간의 핸드오버 비용 차이를 고려해야 한다. 최근, 위성 간 또는 빔 간의 핸드오버를 고려한 연구에 대한 관심이 증가하고 있으나, 현재 연구 태동 단계에 머물러있다. 다층(Multi-Layer) 저궤도 위성 시스템에서 중앙 핸드오버 관리자가 예측된 채널 상태와 위성 위치 정보를 활용하여 핸드오버 시점을 결정하는 방식을 제시하였으나[5], 통신 거리가 긴 위성 통신 환경에서는 글로벌 정보를 수집하는 중앙 관리자를 통한 핸드오버 기법이 급변하는 위성 환경에 실시간으로 대응하기 어렵다는 중대한 한계를 내포하고 있다. 또한, 해당연구는 빔 간과 위성 간 핸드오버 기법을 통합적으로 다루지 않고 별도로 제시하였다. 반면, 위성 간 및 빔 간 핸드오버를 동시에 고려하는 핸드오버 기법이 제안되었으며[11], 해당 방식은 분산화 및 다중 목적 최적화 기법을 활용하여 처리율, 핸드오버 비용, 부하 균형을 각각의 최적화 목표로 설정하였다. 그러나 해당 방식은 각 목표에 대해 개별적인 Q-네트워크를 구축해야 하고, 각 사용자가 세 개의 Q-네트워크를 유지하고 조절해야 하는 등 연산 복잡성이 크게 증가하고 최적화 성능 면에서 한계가 있다. 또한, 다중 빔 환경의 채널 특성을 정밀하게 반영되지 않았다. 따라서, 본 논문에서는 매우 복잡하고 역동적인 다중 빔 저궤도 위성 네트워크에서 발생하는 핸드오버 문제를 효과적으로 해결하기 위해, 연산 복잡성을 최소화하면서도 탁월한 성능과 실시간 적응 능력을 갖춘 중앙 집중 학습 및 분산 실행 (CTDE, Centralized Training Decentralized Execution) 알고리즘인 MAPPO (Multi-Agent Proximal Policy Optimization) 기반 핸드오버 기법을 제안한다. 본 알고리즘은 학습 단계에서 중앙 집중식으로 전역 정보를 활용하여 안정적인 정책 업데이트를 구현하고, 중앙 비평가와 클리핑 기법을 활용하여 환경의 비정상(Non-Stationary) 문제에 효과적으로 대응한다. 또한, 실행 단계에서는 분산 방식으로 작동하여 신속한 처리 및 확장성을 달성한다. 이러한 접근은 기존 중앙화 방식이 제공하는 높은 최적화 성능과 분산 방식의 실시간 적응 능력을 동시에 확보함으로써, 기존 방법들이 가진 한계를 극복하는 데 기여한다. 본 연구의 주요 기여도는 다음과 같다. · 제안된 핸드오버 알고리즘은 각 사용자가 독립적으로 지역 정보를 활용하여 즉각적으로 핸드오버 결정한다. 이때, 우리는 빔 간 또는 위성 간 핸드오버 비용 차이, 사용자 서비스 품질 제약 조건, 그리고 부하 균형을 고려하면서 핸드오버 횟수를 최소화하고, 동시에 처리율(Throughput)을 최대화하는 다중 목적 최적화 문제를 공식화한다. · 우리는 이 최적화 문제를 다중 빔 안테나 이득, 채널 페이딩(Fading) 등 다중 빔 저궤도 위성의 통신 특성을 고려한 MAPPO 최적화 문제로 변환한다. · 시뮬레이션 결과, 제안된 알고리즘은 분산 학습 및 분산 실행(DTDE, Decentralized Training Decentralized Execution) 방식의 알고리즘인 Multi-agent Deep Q-network (MADQN)과 기존 핸드오버 알고리즘에 비해 가장 적은 핸드오버 횟수와 가장 높은 처리율을 보이며 우수한 성능을 입증하였다. Ⅱ. 시스템 모델 및 문제 정의2.1 시스템 모델우리는 다중 빔 저궤도 위성 네트워크에서 연속된 T개의 시간 슬롯 동안의 핸드오버 의사결정 문제를 고려하며, 여기서 총 N개의 저궤도 위성이 J개의 다중빔을 가지고 동일한 궤도 주기로 미리 구성된 궤도면을 따라 계속해서 궤도 운동을 하며, 유한한 관심 지역 A내에 균일하게 분포된 K명의 지상 사용자를 서비스한다. 저궤도 위성의 빔이 충분히 넓은 커버리지 영역을 가지고 있으므로, 각 시간 슬롯 동안 각 유저는 적어도 하나의 빔 커버리지 내에 있다고 가정한다. 그림 1은 고려된 시나리오를 나타낸다. 사용자의 집합은 [TeX:] $$\begin{equation}\boldsymbol{K}=\{1,2, \ldots, k, \ldots K\}\end{equation}$$로 표기한다. 위성의 집합은 [TeX:] $$\begin{equation}\boldsymbol{K}=\{1,2, \ldots, n, \ldots N\}\end{equation}$$로 각 위성의 빔 집합은 [TeX:] $$\begin{equation}\boldsymbol{K}=\{1,2, \ldots, j, \ldots J\}\end{equation}$$로 정의한다. 편의를 위해 우리는 네트워크 내 모든 빔에 관한 새로운 집합인 [TeX:] $$\begin{equation}V=N \times J\end{equation}$$을 정의하며, 위성 n의 j번째 빔을 나타내는 이차원 벡터는 [TeX:] $$\begin{equation}v=(n, j) \in \boldsymbol{V}\end{equation}$$로 표기한다. 각 위성 빔의 커버리지 영역은 원으로 가정하며, 각 빔의 중심은 커버리지 영역의 중심에 위치한다. 시간 슬롯(Time Slot)의 인덱스 집합을 [TeX:] $$\begin{equation}T=\{1, \ldots, T\}\end{equation}$$로 나타낸다. 각 시간 슬롯마다 채널은 준정적 페이딩(Quasi-statci Fading) 겪지만, 시간 슬롯이 변경될 때마다 달라진다. 각 빔의 시스템 대역폭은 BW이다. 각 사용자는 GPS(Global Position System)를 사용해 자신의 위치를 파악하고, 저궤도 위성의 예측 가능한 움직임 덕분에 사용자는 서비스하는 위성의 빔을 인식하게 된다[12]. 저궤도 위성의 높은 이동성 때문에 각 사용자가 사용할 수 있는 위성의 빔이 각 시간 슬롯마다 동적으로 변한다. 따라서 사용자는 매 시간 슬롯마다 어떤 빔과 통신할지 결정해야 한다. 시간 슬롯 t에서 각 위성의 빔 [TeX:] $$\begin{equation}v=(n, j)\end{equation}$$와 사용자 [TeX:] $$\begin{equation}k(\in \boldsymbol{K})\end{equation}$$ 간의 커버리지 인디케이터(Indicator)는 [TeX:] $$\begin{equation}c_{k, i}^t\end{equation}$$로 나타내며, 시간 슬롯 t에서 사용자 k가 빔 v 커버리지 내에 있으면 1, 그렇지 않으면 0으로 정의된다. 따라서, 시간 슬롯 t에서 사용자 k를 커버하는 위성의 빔 집합은 [TeX:] $$\begin{equation}C_k^t \equiv\left\{v \mid c_{k, v}^t=1, v \in \boldsymbol{V}\right\}\end{equation}$$로 나타낸다. 시간 슬롯 t에서 사용자 k와 위성의 빔 v간의 연결은 인디게이터 변수 [TeX:] $$\begin{equation}x_{k, v}^t\end{equation}$$로 나타내며, 이는 사용자 k가 위성의 빔 v에 연결된 경우 1로 정의되며, 그렇지 않으면 0으로 정의된다. 시간 슬롯 t에서 각 위성의 빔 v의 부하는 [TeX:] $$\begin{equation}l_v^t=\sum_{k=1}^K x_{k, v}^t\end{equation}$$로 표현된다. 사용자 k는 자신을 커버하는 위성 빔[TeX:] $$\begin{equation}\left(\forall v \in C_k^t\right)\end{equation}$$에 대한 부하를 지역 정보로 얻을 수 있다. 시간 슬롯 t에서 사용자 k와 모든 빔 간의 연결을 [TeX:] $$\begin{equation}\mathbf{x}_{\mathrm{k}}^{\mathrm{t}}=\left\{x_{k,(1,1)}^t, \ldots, x_{k, v}^t\right\}\end{equation}$$로 나타낸다. 사용자 k는 각 시간 슬롯마다 하나의 빔에만 연결될 수 있으며, 핸드오버는 [TeX:] $$\begin{equation}X_k^t \neq X_k^{t+1}\end{equation}$$일 때 발생한다. 따라서 시간 슬롯 t에서 사용자 k의 핸드오버 비용은 다음과 같이 정의된다.

(1)[TeX:] $$\begin{equation} \varphi_k^t=\left\lbrace\begin{array}{ll} \xi, & \text { if } X_k^t \neq X_k^{t+1} \text { and } \mathrm{E}_1 \text { (위성 간 핸드오버) } \\ \zeta, & \text { if } X_k^t \neq X_k^{t+1} \text { and } \mathrm{E}_2 \text { (빔 간 핸드오버) } \end{array}\right. \text {. } \end{equation}$$여기서, E1, E2는 [TeX:] $$\begin{equation} \begin{aligned} \mathrm{E}_1: \rho_k(t) & \neq \rho_k(t+1), \rho_k(t)=n \in \boldsymbol{N}, \\ \mathrm{E}_2: \rho_k(t) & =\rho_k(t+1) \text { and } \delta_k(t) \\ & \neq \delta_k(t+1), \delta_k(t)=j \in \boldsymbol{J} \end{aligned} \end{equation}$$ 이고, [TeX:] $$\begin{equation}\rho_k(t), \delta_k(t)\end{equation}$$는 각각 시간 슬롯 t에서 사용자 k와 연결된 위성과 대응하는 빔을 나타낸다. 핸드오버는 위성 간 핸드오버와 빔 간 핸드오버 두 가지로 구분되며, 위성 간 핸드오버는 다른 위성의 빔으로 전환되는 경우를 의미한다. 특히, 두 핸드오버 방식에는 발생 비용에 차이가 있다. 빔 간 핸드오버인 경우 같은 위성 내에서 이뤄지기 때문에 리소스를 재할당이 상대적으로 수월하다. 그러나 위성 간 핸드오버인 경우 타겟(Target) 위성에게 핸드오버 요청을 보내고 핸드오버 승인을 받아야 하는 과정이 추가된다. 따라서 일반적으로 위성 간 핸드오버가 더 높은 신호 비용(Signalling Cost)과 신호 지연(Signalling Delay)[5]로 인해 더 높은 핸드오버 비용[TeX:] $$\begin{equation}(0 \ll \zeta<\xi)\end{equation}$$을 발생시킨다. 시간 슬롯 t에서 사용자 k와 위성 빔 v간의 안테나 이득을 포함한 채널 이득은 다음과 같이 나타낸다[10,13].

(2)[TeX:] $$\begin{equation}\left|h_{k, v}^t\right|^2=\frac{G^T G^R|\Psi|^2}{\left(4 \pi \frac{d_{k, v}}{\lambda}\right)^2} .\end{equation}$$여기서 GT, GR은 각 위성의 빔 송신, 사용자 수신 안테나 이득이며, ψ는 쉐도우 라이시안 페이딩(Shadowed-Rician-fading) 나타내며, dk,v는 사용자와 빔 사이의 거리이며, λ는 파장이다. 이때 GT와 GR은 위성과 사용자의 안테나 방사 패턴에 의해 결정된다는 점을 유의해야 한다. 구체적으로 ITU-R S.1528[14]를 참조하면 위성의 안테나 방사 패턴은 다음과 같다.

(3)[TeX:] $$\begin{equation} G^T(\theta)=\left\lbrace\begin{array}{ll} G_{\max }^T & \theta \leqq \theta_b \\ G_{\max }^T-3\left(\theta / \theta_b\right)^2 & \theta_b\lt\theta \leqq Y \\ G_{\max }^T+L_F-25 \log _{10}(\theta / Y) & Y\lt\theta \leqq Z \\ L_F & Z\lt\theta \end{array} .\right. \end{equation}$$여기서 θ(°, 도 단위)는 오프 축 각도(Off-Axis Angle)이며 θb는 3dB 빔폭 θ3dB의 절반이다. [TeX:] $$\begin{equation}G_{\max }^T\end{equation}$$는 송신 안테나의 최대 이득을 나타내며, [TeX:] $$\begin{equation}G_{\max }^T=10 \log _{10}\left[4.93\left(\frac{70}{\theta_{3 d B}}\right)^2\right]\end{equation}$$으로 계산한다. [TeX:] $$\begin{equation}Z=Y \times 10^{0.04\left(G_{\max }^T+L_{\mathrm{g}}-L_F\right)}\end{equation}$$에서 Ls는 주빔(Main Beam)과 피크(Peak) 이득 아래의 내부 측엽 마스크(Near-In Side-Lobe Mask) 교차점을 나타내며, [TeX:] $$\begin{equation}L_F=0 d B i\end{equation}$$는 외부 측엽(Far-Out Side-Lobe) 레벨(Level)이고, [TeX:] $$\begin{equation}Y=1.5 \theta_b\end{equation}$$다. ITU-R S.465-6[15]을 참조하면 사용자 터미털(Termianl)의 안테나 방사 패턴은 다음과 같다.

(4)[TeX:] $$\begin{equation}G^R(\theta)= \begin{cases}G_{\max }^R & \theta \leqq \theta_{\min } \\ 32-25 \log _{10}(\theta) & \theta_{\min }<\theta \leqq 48^{\circ} \\ -10 & 48^{\circ}<\theta\end{cases}\end{equation}$$여기서 [TeX:] $$\begin{equation}\theta_{\min }=\max \left(2^{\circ}, 144(D / \lambda)^{-1.09}\right)\end{equation}$$이고, [TeX:] $$\begin{equation}G_{\max }^R=10 \log _{10}\left[\left(\frac{\pi D}{\lambda}\right)^2\right]\end{equation}$$는 수신 안테나의 최대 이득이다. 이때 D는 사용자 안테나 개구면(Aperture)의 직경이다. 빔 v의 송신 전력은 Pv로 나타내며, 문제의 복잡성을 줄이고자 위성의 총 전력 PSAT가 위성의 빔들에게 균등하게 분배된다고 가정한다(즉, Pv=PSAT/J). 간섭은 부하 수에 따라 대역폭 BW을 공유하여 사용함에 따라 간섭은 존재하지 않음을 가정한다. 따라서 시간 슬롯 t에서 위성 빔 v에 의해 서비스되는 사용자 k와의 신호 대 잡음 비율(SNR, Signal-to-Noise ratio)은 다음과 같이 표현된다.

(5)[TeX:] $$\begin{equation}S N R_{k, v}^t=\frac{P_v\left|h_{k, v}^t\right|^2}{\sigma^2} .\end{equation}$$여기서 [TeX:] $$\begin{equation}\sigma^2=\kappa T_{\text {noise }} B_W / l_v^t\end{equation}$$는 잡음 전력을 나타내며, [TeX:] $$\begin{equation}\kappa, T_{\text {noise }}\end{equation}$$는 각각 볼츠만 상수(Boltzmann’s Constant), 수신기 잡음 온도를 나타낸다. 더 나아가, 수식 (2)-(5)을 정리하면, 시간 슬롯 t에서 빔 v에 의해 서비스되는 사용자 k의 성취 가능한 처리율(Achievable Throughput)은 다음과 같이 표현할 수 있다.

(6)[TeX:] $$\begin{equation}R_{k, v}^t=\frac{B_W}{l_v^t} \log _2\left(1+S N R_{k, v}^t\right)\end{equation}$$이때 우리는 사용자의 목표 서비스 품질을 만족시키고자, 사용자는 각자 최소 처리율([TeX:] $$\begin{equation}R_{k, v}^t \geqq R_k^{t h}\end{equation}$$)을 만족한다고 가정한다. 2.2 최적화 문제 정의본 논문에서는 다중 빔 저궤도 위성의 효율적인 핸드오버 관리를 위해, T시간 슬롯 동안 위성 또는 빔 간 핸드오버의 비용 차이, 부하 균형, 그리고 서비스 품질 제약 조건을 고려하며 핸드오버 발생을 최소화하고 동시에 처리율을 최대화하는 것을 목표로 한다. 이에 따라 최적화 문제를 정의하면 다음과 같다.

(7)[TeX:] $$\begin{equation}\mathrm{P}: \min _{x_{k, v}^t} \sum_{t=1}^T \sum_{k=1}^K \varphi_k^t-\sum_{v \in V} x_{k, v}^t\left(\omega_R R_{k, v}^t\right)\end{equation}$$

(8)[TeX:] $$\begin{equation}\text { s.t. } x_{k, v}^t \in\{0,1\}, \forall v \in \boldsymbol{V} \text {, }\end{equation}$$

(10)[TeX:] $$\begin{equation}\sum_{v \in \boldsymbol{V}} x_{k, v}^t R_{k, v}^t \geqq R_k^{t h}, \quad \forall k \in \mathbf{K} .\end{equation}$$여기서 ωR은 처리율 값을 스케일링(Scaling)하는 요소이다. 제약사항 (8)과 (9)는 각 사용자가 매 시간 슬롯마다 커버리지 내에 있는 오직 하나의 빔과 연결됨을 의미한다. Ⅲ. 제안된 다중 빔 저궤도 위성 위한 다중 에이전트 심층 강화 학습 기반 핸드오버 전략최적화 문제 (7)의 주요 목표는 사용자가 커버리지 내에 있는 빔들의 부하나 채널 정보 같은 현재 및 지역 정보를 기반으로 장기간(Long-term)적인 성능을 극대화 하는 것이다. MADRL은 복잡한 무선 통신 환경에서 고차원 상태 공간 및 행동 공간을 가진 다중 의사 결정자(또는 행동자, Actor)가 도전적인 문제를 해결하기 위한 탁월한 접근법이다[16]. MADRL은 동적으로 변화는 환경에서 에이전트들이 자신의 지역 정보를 기반으로 숨겨진 패턴(Hidden Pattern)을 학습할 수 있으므로 문제를 최적화할 수 있다. 따라서, 본 장에서는 최적화 문제 (7)를 MADRL 프레임워크(Framework)로 공식화한다. 3.1 다중 에이전트 심층 강화학습 공식화최적화 문제 (7)를 MADRL 기반으로 해결하기 위해서는 최적화 문제를 분산된 부분 관측 마르코프 결정 과정(Dec-POMDP, Decentralized Partially Observable Markov Decision Process)[17] 프레임워크로 공식화해야 한다. 구체적으로 Dec-POMDP의 에이전트, 관측(Observation), 행동(Action) 그리고 보상(Reward)를 정의 내리면 다음과 같다. 1) 에이전트: 각 사용자 [TeX:] $$\begin{equation}k \in \mathbf{K}\end{equation}$$가 하나의 에이전트로써 다른 에이전트 및 환경과 상호작용한다. 2) 관측: 각 시간 슬롯 t마다 사용자는 환경과 상호작용하면서 관측된 값을 업데이트한다. 사용자 k의 관측(상태)[TeX:] $$\begin{equation}s_k^t\end{equation}$$은 다음과 같이 정의된다.

(11)[TeX:] $$\begin{equation}s_k^t=\left\langle h_{k, v}^t, l_v^t, a_k^{t-1}\right\rangle, \forall v \in C_k^t\end{equation}$$여기서 [TeX:] $$\begin{equation}a_k^{t-1}\end{equation}$$는 특징 정보(Fingerprint)로, 사용자 k의 이전 시간 슬롯에서의 행동 정보이다. 특징 정보 기반 MADRL은 리플레이 버퍼를 안정화를 통해 비정상성(Non-Stationary) 환경에서 보다 안정적인 학습을 가능하게 한다[18]. 이때 관측은 [TeX:] $$\begin{equation}2 \times N J+1\end{equation}$$로 고정된 크기를 갖는 평탄화된 행벡터이고, 커버리지 내에 없는 빔의 정보는 –1로 설정한다. 채널과 부하 정보는 위성의 방송을 통해 얻을 수 있다. 3) 행동: 시간 슬롯 t때 사용자 k의 행동은 커버리지 내 빔 중 하나를 선택하는 것이다. 즉, [TeX:] $$\begin{equation} a_k^t=v, \forall v \in C_k^t \end{equation}$$이다. 4) 보상: 시간 슬롯 t때 사용자 k의 보상 [TeX:] $$\begin{equation}r_k^t\end{equation}$$ 는 다음과 같다.

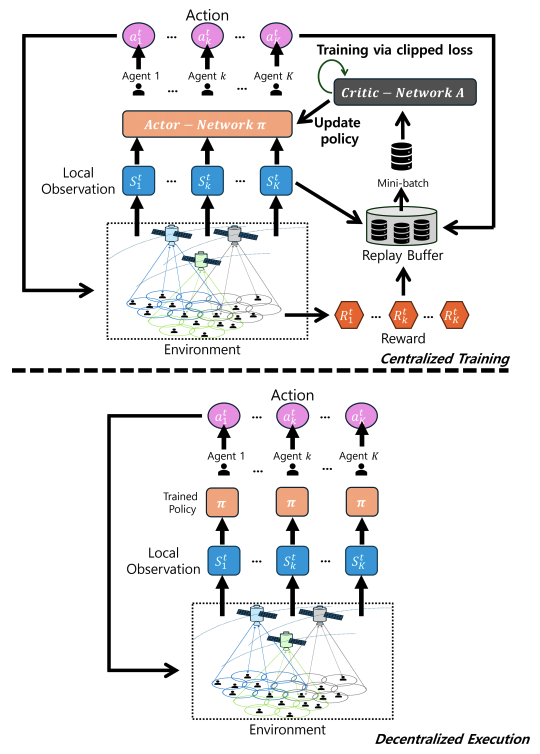

(12)[TeX:] $$\begin{equation}r_k^t= \begin{cases}-\varsigma & \text { if } R_{k, a_k^t}^t<R_k^{t h}, \\ -\varphi_k^t & \text { if } a_k^{t-1} \neq a_k^t \text { and } R_{a_k^t}^t \geqq R_k^{t h}, \\ \min \left(R_{A c k}, \omega_R R_{k, v}^t\right) & \text { otherwise. }\end{cases}\end{equation}$$여기서 -ς는 사용자 k가 목표 사용자 서비스 품질 [TeX:] $$\begin{equation}R_k^{t h}\end{equation}$$을 만족시키지 못한 통신 장애(Outage)에 대한 페널티(핸드오버 여부와 무관하게 적용됨)이다. [TeX:] $$\begin{equation}-\varphi_k^t\end{equation}$$는 서비스 품질을 만족하고 핸드오버가 일어났을 때 페널티(즉, 핸드오버 성공에 대한 페널티)이다. RAck는 처리율의 편차가 크기 때문에 너무 큰 보상을 방지하는 특정 고정 값이다. 3.2 제안된 Multi-Agent Proximal PolicyOptimization 알고리즘본 절에서는 앞서 정의한 MADRL 프레임워크을 활용하여 최적화할 수 있는 MAPPO 알고리즘을 제안한다. 그림 2는 우리가 제안하는 MAPPO의 구조를 나타낸다. MAPPO는 CTDE 구조를 따른다. 학습 단계에서는 중앙 비평가(Critic) 네트워크가 모든 에이전트의 상태, 행동, 보상 정보를 통합하여, 에이전트 간의 상호작용을 고려하여 학습을 최적화(정책 업데이트)한다. 이때 우리가 제안하는 MAPPO 구조는 모든 에이전트가 동일한 정책 [TeX:] $$\begin{equation}\pi(a \mid s)\end{equation}$$을 공유하며, 각 에이전트(사용자)는 자신이 얻을 수 있는 지역 정보(즉, 관측 정보)를 바탕으로 독립적으로 행동을 결정한다. 학습이 완료된 후, 각 에이전트는 중앙 평가없이 학습된 정책을 바탕으로 독립적으로 실행된다. 이와 같은 방식은 DTDE에 비해 협력적인 환경에서 효율적이며, 복잡한 환경에서도 높은 성능을 발휘할 수 있다. MAPPO의 핵심 개념은 행위자-비평가(Actor-Critic) 구조와 클리핑(Clipping) 기법이다. 행위자-비평가 구조는 에이전트가 상태(또는 관측)의 가치 V(s)를 학습하고 평가하는데, 이때 이점 함수(Advantage Function) [TeX:] $$\begin{equation}A_k^t\end{equation}$$를 활용한다. 이점 함수는 정책을 업데이트할 때, 행동의 상대적 가치를 평가하는데 사용되며, 상태 [TeX:] $$\begin{equation}s_k^t\end{equation}$$에서 취한 행동 [TeX:] $$\begin{equation}a_k^t\end{equation}$$가 얼마나 좋은지를 계산한다.

여기서 Rt는 상태 [TeX:] $$\begin{equation}s_k^t\end{equation}$$에서 얻은 실제 보상이다. 즉, 이점 함수는 비평가가 평가한 상태 가치와 실제로 얻은 보상 간의 차이를 계산하여, 행위자가 더 나은 행동을 선택할 수 있도록 정책 업데이트를 유도한다. 클리핑 비율 rt(θ)는 다음과 같이 정의된다.

(14)[TeX:] $$\begin{equation}r^t(\theta)=\frac{\pi_\theta\left(a_k^t \mid s_k^t\right)}{\pi_{\text {old }}\left(a_k^t \mid s_k^t\right)}\end{equation}$$여기서 [TeX:] $$\begin{equation}\pi_\theta\left(a_k^t \mid s_k^t\right)\end{equation}$$는 새로운 정책에서 상태 [TeX:] $$\begin{equation}s_k^t\end{equation}$$에서 행동 [TeX:] $$\begin{equation}a_k^t\end{equation}$$를 선택한 확률이고, [TeX:] $$\begin{equation}\pi_{\text {old }}\left(a_k^t \mid s_k^t\right)\end{equation}$$는 이전 정책에서 상태 [TeX:] $$\begin{equation}s_k^t\end{equation}$$에서 행동 [TeX:] $$\begin{equation}a_k^t\end{equation}$$을 선택할 확률이다. 이 비율은 새로운 정책이 이전 정책과 얼마나 다른지를 나타낸다. MAPPO는 클리핑된 정책 비율을 사용하여 손실 함수를 다음과 같이 정의한다.

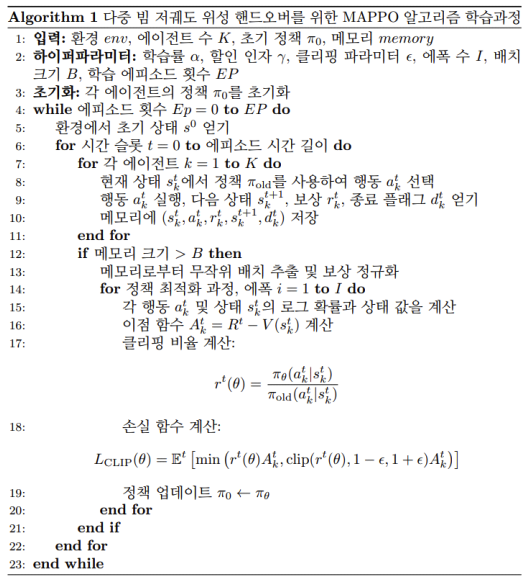

(15)[TeX:] $$\begin{equation} \begin{aligned} & L_{\text {CLIP }}(\theta)= \\ & \quad \mathbb{E}\left[\min \left(r^t(\theta) A_k^t, \operatorname{clip}\left(r^t(\theta), 1-\epsilon, 1+\epsilon\right) A_k^t\right)\right] \end{aligned} \end{equation}$$여기서 은 클리핑 파라미터(Parameter)로 정책이 지나치게 변하지 않도록 설정된 범위다. 즉, 이 손실 함수는 정책 업데이트 시 너무 큰 변화가 일어나지 않도록 클리핑하며, 학습 과정에서 정책의 안정적인 업데이트를 보장한다. MAPPO는 위에서 언급한 대로 CTDE 구조로 동작하기 때문에, 복잡하고 협력적인 동적 환경에 대한 적응성이 뛰어나다. 또한, 안정적인 정책 업데이트를 위한 클리핑 기법과 이점 함수를 활용하여, 주어진 우리의 최적화 문제를 효과적으로 해결할 수 있다. 전반적인 MAPPO의 학습과정에서의 의사코드(Pseudocode)는 그림 3을 통해 기술했다. Ⅳ. 시뮬레이션 결과 및 성능 분석4.1 시뮬레이션 파라미터우리는 다중 빔 저궤도 위성이 정해진 궤도를 따라 움직이며, 반경 70km인 원 내부에 균일하게 분포된 지상 사용자들과 시간 슬롯 간격 1초로 총 40 슬롯 동안 통신하는 시뮬레이션을 진행하였다. 또한, 각 위성은 반경 약 100km의 빔 커버리지를 통해 서비스를 제공하며, 매 시간 슬롯마다 사용자가 1~5개의 빔 커버리지 영역 내에 위치하여 시뮬레이션 기간 동안 지속적으로 통신 서비스를 받는 상황을 고려하였다. 자세한 시스템 파라미터는 표 1에 정리했다. 제안된 MAPPO의 네트워크 및 학습 파라미터는 표2에 정리했다. 행위자 네트워크는 주어진 상태에서 적절한 행동을 선택하는 네트워크로, 입력 크기는 관측 정보의 크기이고, 출력 크기는 행동 공간의 크기이다. 비평가 네트워크는 주어진 상태에 대한 가치를 평가하는 네트워크로, 입력 크기는 관측 정보의 크기이고, 출력의 크기는 해당 상태의 가치이므로 1이다. 보상과 관련된 값 [TeX:] $$\begin{equation}-\varsigma=-10,-\xi=-5,-\zeta=-0.1, \omega_R=10^{-7}, R_{\text {Ack }}=10\end{equation}$$로 설정되었다. 표 1. 시스템 파라미터

표 2. MAPPO 네트워크 및 학습 파라미터

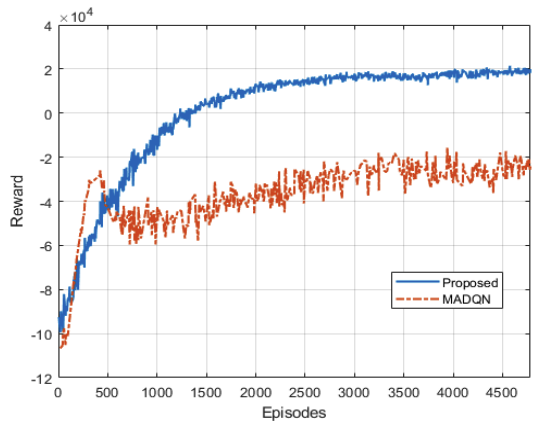

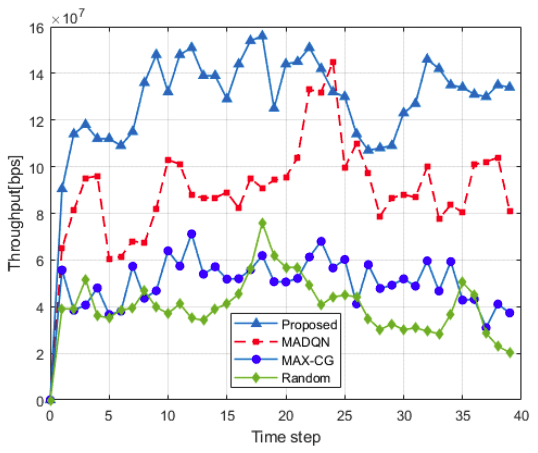

본 논문에서는 제안된 핸드오버 방식(MAPPO)을 다음과 같은 3가지 알고리즘과 비교한다. 1) 무작위(Random) 핸드오버 알고리즘[19]: 사용자가 매 시간 슬롯마다 커버리지 내에 있는 빔 중 하나를 무작위로 선택한다. 2) 최대 채널 이득(MAX-CG) 핸드오버 알고리즘[1]: 사용자가 매 시간 슬롯마다 커버리지 내에 있는 빔 중 채널 이득이 제일 큰 빔을 선택한다. 3) Multi-agent Deep Q-network (MADQN) 핸드오버 알고리즘[1]: DTDE 방식으로 사용자는 매 시간 슬롯마다 MADQN 통해 최적화 된 정책을 따라 빔을 선택한다. 4.2 복잡도 및 수렴 분석제안된 MAPPO 학습과정에서의 복잡도를 표 2를 참고하여 분석하면 다음과 같다. 1) 행위자 네트워크: [TeX:] $$\begin{equation}O((2 \times N \times J+1) \times 256+256 \times(N \times J))=O(N \times J)\end{equation}$$ 2) 비평가 네트워크: [TeX:] $$\begin{equation}O((2 \times N \times J+1) \times 256+256 \times 1)=O(N \times J)\end{equation}$$ 따라서 MAPPO 학습과정에서의 총 복잡도는 다음과 같다. [TeX:] $$\begin{equation}O(N \times J)+O(N \times J)=O(N \times J)\end{equation}$$ MAPPO는 수렴성을 보장하기 위해 클리핑 기법, 이점 함수 기반 업데이트, 그리고 중앙 비평가과 같은 여러 요소들을 활용한다. 그림 4는 제안된 알고리즘의 훈련 과정에서의 에피소드 보상 값의 변화를 보여준다. 이를 통해, 제안된 알고리즘은 훈련 에피소드가 증가할 수록 에피소드 보상 값이 점진적으로 증가하고, 약 3000 에피소드 이후부터 수렴하는 것을 확인할 수 있다. 이때, 제안된 방식이 DTDE 방식인 MADQN에 비해 수렴 값이 약 200% 더 좋은 것을 확인할 수 있다. 이는 우리가 제안한 CTDE 방식의 MAPPO 알고리즘이 보다 효과적으로 최적화 문제를 해결한 결과이다. 4.3 성능 비교표 3은 핸드오버 알고리즘에 따른 성능 비교표이다. 각 요소는 총 40 슬롯의 에피소드 중 첫 번째 슬롯을 제외한 39 슬롯 동안의 성능을 측정한 값이다. QoS’는 최소 처리율을 만족시키지 못한 횟수를 나타내며, 총 핸드오버, HO는 빔 간 핸드오버, BHO 또는 위성 간 핸드오버, SHO 발생 횟수를 합친 값이다. Ack는 서비스 품질을 만족시키면서 핸드오버가 발생하지 않은 횟수를 의미한다. 결과적으로, 제안된 알고리즘은 다른 알고리즘 대비 약 39.13% - 75.33% 적은 핸드오버를 발생시켜 성능이 우수함을 확인할 수 있다. 그림 5는 에피소드 동안의 사용자의 평균 처리율을 나타낸다. 해당 결과를 통해, 우리가 제안한 방식이 평균적으로 가장 우수한 처리율을 보인다는 것을 확인할 수 있다. 표 3과 그림 5의 결과를 종합해 보면, 제안된 알고리즘은 비교 알고리즘에 비해 가장 적은 핸드오버 횟수와 가장 높은 평균 처리율을 보였으며, 이는 최적화 문제 (7)를 매우 효과적으로 해결한 결과라고 할 수 있다. Ⅴ. 결 론본 논문에서는 CTDE 방식의 MADRL 알고리즘인 MAPPO 기반 다중 빔 저궤도 위성 핸드오버 전략을 제안하였다. 제안된 방식은 저궤도 위성 다중 빔 채널 특성을 반영하며, 빔 간 및 위성 간 핸드오버 비용 차이, 사용자 서비스 품질 제약 조건, 그리고 부하 균형을 고려하면서, 핸드오버 횟수 최소화하고 처리율 최대화한다. 제안된 알고리즘은 각 사용자가 독립적으로 지역 정보(커버리지 내 부하 수 및 채널 정보)를 바탕으로 핸드오버 결정을 하며 이는 복잡하고 동적인 다중 빔 저궤도 위성에 즉각적으로 대응할 수 있다. 시뮬레이션 결과, 제안된 알고리즘은 비교 알고리즘 대비 가장 적은 핸드오버 횟수와 가장 높은 처리율을 보이며 우수한 성능을 보였다. BiographyBiography김 태 훈 (Taehoon Kim)2011년 2월: 한양대학교 정보통신공학부 (공학사) 2013년 2월: 한국과학기술원 전기및전자공학과 (공학석사) 2017년 8월: 한국과학기술원 전기및전자공학부 (공학박사) 2017년 9월~2020년 2월: 국방과학연구소 국방첨단기술연구원 선임연구원 2020년 3월~2022년 9월: 국립한밭대학교 컴퓨터공학과 조교수 2022년 10월~현재: 국립한밭대학교 컴퓨터공학과 부교수 <관심분야> Wireless Communications, Satellite Communications, Wireless Network Security [ORCID:0000-0002-9353-118X] Biography방 인 규 (Inkyu Bang)2010년 2월 : 연세대학교 전기전 자공학부 (공학사) 2012년 1월 : 한국과학기술원 전 기및전자공학과 (공학석사) 2017년 8월 : 한국과학기술원 전 기및전자공학부 (공학박사) 2017년 9월~2019년 2월 : 싱가 포르 국립대학 컴퓨터과학과 박사후연구원 2019년 3월~2019년 7월 : 국방과학연구소 지상기술연 구원 선임연구원 2019년 8월~2022년 9월 : 국립한밭대학교 정보통신공 학과 조교수 2022년 10월~현재 : 국립한밭대학교 지능미디어공학 과 부교수 <관심분야> 6G/5G, 무선네트워크보안, 이동통신보안, 물리계층보안, 위성통신, 인공지능 무선통신 응용 [ORCID:0000-0001-7109-1999] Biography채 승 호 (Seong Ho Chae)2010년 2월 : 성균관대학교 정보 통신공학부 (공학사) 2012년 2월 : 한국과학기술원 전 기 및 전자공학과 (공학석사) 2016년 2월 : 한국과학기술원 전 기 및 전자공학부 (공학박사) 2016년 3월~2016년 9월 : 한국 과학기술원 정보전자연구소 연수연구원 2016년 10월~2018년 2월: 국방과학연구소 선임연구원 2018년 3월~2023년 8월 : 한국공학대학교 전자공학부 조교수 2023년 9월~현재 : 한국공학대학교 전자공학부 부교수 <관심분야> 6G 통신 시스템, 저궤도 위성통신, 에지컴퓨팅, 인공지능 무선통신 응용 [ORCID:0000-0001-9092-5039] References

|

StatisticsCite this articleIEEE StyleC. Lee, T. Kim, I. Bang, S. H. Chae, "Handover Minimization Scheme Using Multi-Agent Deep Reinforcement Learning in Multi-Beam Low Earth Orbit Satellites," The Journal of Korean Institute of Communications and Information Sciences, vol. 50, no. 8, pp. 1196-1206, 2025. DOI: 10.7840/kics.2025.50.8.1196.

ACM Style Chungnyeong Lee, Taehoon Kim, Inkyu Bang, and Seong Ho Chae. 2025. Handover Minimization Scheme Using Multi-Agent Deep Reinforcement Learning in Multi-Beam Low Earth Orbit Satellites. The Journal of Korean Institute of Communications and Information Sciences, 50, 8, (2025), 1196-1206. DOI: 10.7840/kics.2025.50.8.1196.

KICS Style Chungnyeong Lee, Taehoon Kim, Inkyu Bang, Seong Ho Chae, "Handover Minimization Scheme Using Multi-Agent Deep Reinforcement Learning in Multi-Beam Low Earth Orbit Satellites," The Journal of Korean Institute of Communications and Information Sciences, vol. 50, no. 8, pp. 1196-1206, 8. 2025. (https://doi.org/10.7840/kics.2025.50.8.1196)

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||